Les 13,8 millions de bénéficiaires de la CAF sont évalués par un algorithme qui accentue les contrôles et la détection de fraudes potentielles. Ce ‘score’, perçu comme discriminatoire par certaines associations, est néanmoins défendu par l’organisme.

Les Caisses d’Allocations Familiales (CAF) sont au centre d’une controverse croissante. Des questions se posent quant à l’utilisation d’algorithmes dans leurs processus de détection de fraude et d’attribution des aides. Voici comment il y a discrimination algorithmique de la CAF car ces outils numériques peuvent influencer la vie des allocataires les plus précaires, soulevant des préoccupations éthiques et sociales majeures.

Comprendre le fonctionnement des algorithmes de la CAF

Les Caisses d’Allocations Familiales utilisent des algorithmes, depuis 2010 selon une enquête du Monde, pour analyser et identifier les cas potentiels de fraude pour les allocations familiales, à savoir les prestations familiales,les APL, la Prime d’activité, le RSA, allocation de rentrée scolaire, les différentes aides pour enfants handicapés, le taux d’incapacité en cas de souci de santé,…

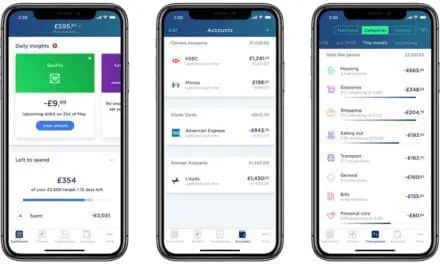

Ces outils numériques, basés sur des techniques de data mining, évaluent les risques en attribuant un « score de suspicion » à chaque dossier. C’est ainsi que chaque allocataire peut faire l’objet d’un contrôle inopiné par la CAF pour s’assurer de l’exactitude de sa déclaration. Pour gérer efficacement les vérifications, la CAF identifie préventivement les dossiers présentant un risque potentiel. Ce processus automatisé, bien que conçu pour améliorer l’efficacité, suscite des inquiétudes quant à son impartialité envers les groupes socialement vulnérables.

Cette note fluctue de 0 à 1, où un score proche de 1 indique un niveau de suspicion élevé pour l’individu concerné.

Les critiques de la discrimination algorithmique de la CAF

Une enquête menée par la Quadrature du Net souligne que l’algorithme pourrait involontairement cibler les individus aux revenus irréguliers ou ceux vivant dans des quartiers défavorisés. L’enquête menée par l’association révèle que la complexité inhérente au remplissage des formulaires standards peut significativement influencer cette notation. Par exemple, des preuves de revenus trimestriels irréguliers, diversifiés ou compliqués à aligner avec des critères préétablis, sont susceptibles de déclencher des alertes de fraude.

Il apparaît, par exemple, que les familles monoparentales sont particulièrement ciblées par les contrôles. Bien qu’elles ne constituent que 16 % des ménages bénéficiaires d’aides, elles subissent 36 % des vérifications à domicile. De plus, d’après l’enquête du Monde, deux tiers de ces inspections concernent les ménages les plus démunis.

Dans les cas de régularisation, 31 % s’avèrent favorables à l’allocataire, tandis que 69 % se révèlent soit neutres, soit défavorables aux personnes concernées. Avant les investigations de la Quadrature du Net, Jacques Toubon, ancien Défenseur des droits, avait critiqué en 2020 cette approche, la qualifiant de basée sur des ‘préjugés et des stéréotypes‘.

Cette situation pose la question de la discrimination algorithmique, où des personnes déjà en situation de précarité se retrouvent disproportionnellement affectées par les contrôles des CAF.

Réponses de la CAF

L’algorithme « ne sert pas seulement à lutter contre la fraude. Il permet surtout d’identifier les erreurs, d’ailleurs en défaveur mais aussi en faveur des allocataires : 31 % des régularisations post contrôles sont en faveur de l’allocataire qui reçoit un complément financier.«

Vers une meilleure transparence et équité

L’importance de la transparence et de l’équité dans l’utilisation des algorithmes par les institutions publiques est de mise. Des efforts sont nécessaires pour garantir que ces outils n’engendrent pas de nouvelles formes de discrimination, surtout envers les plus vulnérables.